この講座の対象者は以下の方を想定しています。

- 数学は中学レベルしか分からないけど統計検定2級に合格したい

- どの参考書を見ても数式だらけで理解できない

- 重回帰分析とは?

- 単回帰と何が違うの?

この講座では特に、0の状態から統計検定2級に合格したいって方のために、分かりやすさをモットーに解説していきます。

今回は、重回帰分析について解説します。

回帰分析についてよくわからないという方はコチラの講座を受けてから重回帰分析を学びましょう。

重回帰分析とは?

単回帰分析では説明変数がひとつでした。

そのひとつの変数で目的変数を予測するのでしたね!

では重回帰分析が何かというと、説明変数が複数の場合です。

身長という説明変数から目的変数である体重を予測するのが単回帰分析です。

重回帰の場合にはこれが、[身長、体脂肪率、筋肉量、年齢]など、複数の説明変数から目的変数の値を予測します。

重回帰分析の回帰式

単回帰分析の時の回帰式は↓でした。

$y=β_0+β_1x$

これが、説明変数が4つ[身長、体脂肪率、筋肉量、年齢]の場合の重回帰分析になると、↓になります。

$y=β_0+β_1x_1+β_2x_2+β_3x_3+β_4x_4$

$β_0$は切片のまま変わらす、$β$の数は説明変数の数によって増減します。

今回は説明変数が4つなので$β_4$まであります。

また、重回帰分析も単回帰分析と同じく最小2乗法で求めます。

重回帰分析の結果の見方

統計検定で大事になってくるのは回帰分析の結果からどのような情報が得られるのか?

その見方が重要になってきます。

例えば、サンプルデータを用いて、

- 説明変数:[身長、体脂肪率、筋肉量、年齢]

- 目的変数:[体重]

の重回帰分析を行った結果が↓です。

| 回帰係数 | 標準誤差 | t値 | P値 | |

| 切片 | 24.5157 | 5.341 | 4.590 | 0.000 |

| 身長 | 0.3820 | 0.029 | 12.961 | 0.000 |

| 体脂肪率 | 0.1661 | 0.027 | 6.147 | 0.000 |

| 筋肉量 | 0.0403 | 0.039 | 1.037 | 0.302 |

| 年齢 | 0.0312 | 0.022 | 1.437 | 0.154 |

重回帰式

結果を見ると、各説明変数の回帰係数が分かりますね。

これを使って、重回帰式がつくれます。

$\hat{y}=24.5157+0.382x_1+0.1661x_2+0.0403x_3+0.0312x_4$

これによって、各説明変数の値が分かれば、目的変数の値を推定することができます。

例えば、身長が1増えるごとに体重の推定値は$0.3820$ずつふえていき、体脂肪率が1増えると、$0.1661$ずつ増えるというのが分かります。

$\hat{y}$のあたまについている $\hat{}$ (ハット)は、統計学では推定値を表しています。

ようは、「確実にこの値になる」というよりは、「この値になる可能性が高いよね」というニュアンスです。

結果を見る

そのほかの結果の見方としては、前回の講座で説明しましたので、簡単に説明します。

何度も言いますが、統計検定では回帰分析は結果の見方を問われる問題が多いです。

しっかりと抑えましょう。

標準誤差

回帰係数のばらつきを表す統計量でしたね。

標準誤差は、回帰係数が真の値からどの程度離れているかを表しています。

結果をみると、説明変数では筋肉量のばらつきがわずかながら一番大きいことが分かります。

t値

回帰係数の統計的有意性を示す統計量です。

t値が大きいほど、説明変数が目的変数に与える影響が大きいです。

今回の場合ですと、身長が体重に与える影響が一番大きいことが分かります。

また筋肉量と年齢の説明変数に関しては、2以下の値となっているため、体重に影響しないと判断して良さそうです。

P値

p値とは、回帰係数が0であるという帰無仮説が真である確率です。

p値が小さいほど、回帰係数が0ではないという対立仮説が真である可能性が高くなります。

意味あいとしてはt値と逆の意味あいに近いです。

今回の結果ですと、身長と体脂肪率に関しては「0.000」と非常に小さい値のために、帰無仮説(回帰係数が0)が棄却されます。

筋肉量と年齢に関しては、有意水準を0.05にすると、帰無仮説を棄却することができないことが分かります。

決定係数と自由度調整済み決定係数

前回の講座で決定係数の説明を簡単にしましたが、もう少し深堀りしていきましょう。

まず決定係数とは、回帰直線の説明力の指標でした。

決定係数の値は、0から1までの範囲で、1に近いほど当てはまりが良いことを表しています。

例えば、説明変数が4つで決定係数が「0.80」という結果になったとしたら、4つの説明変数を用いた回帰モデルによって、目的変数の約80%を説明できていることを表しています。

自由度調整済み決定係数とは?

決定係数には、もうひとつ自由度調整済み決定係数というものがあります。

これらは英語表記されることもおおく、

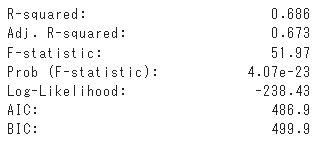

- 決定係数:R-squared

- 自由度調整済み決定係数:Adj. R-squared

と、書かれることも多いです。

Adj. R-squaredは、adjusted R-squaredの略です。

決定係数は、性質上どうしても説明変数の数が増えるほど、1に近づいてしまいます。

そのため説明変数が多いモデルほど、勝手に決定係数が1に近づき、実際の当てはまりとズレが生じる場合があります。

それを補正してくれるのが、自由度調整済み決定係数です。

例えば、pythonで重回帰分析を行った結果が↓です。

これを見ると、決定係数が「0.686」で自由度調整済み決定係数が「0.673」となっています。

説明変数が4つの場合の結果ですので、その分を自由度調整済み決定係数では補正しているため、値が小さくなっています。

このように、説明変数が多いモデルの場合には、自由度調整済み決定係数を参考にすることが大切です。

Work illustrations by Storyset